Quest 3 Depth API für dynamische Mixed-Reality-Okklusion veröffentlicht

Meta hat die Depth API für Quest 3 als experimentelle Funktion für Entwickler veröffentlicht, um dynamische Okklusion für Mixed Reality zu testen.

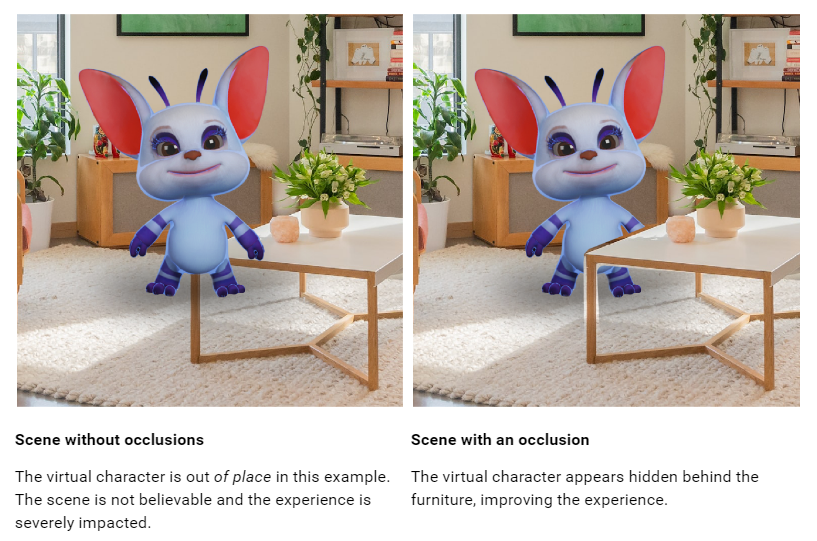

In unserem Testbericht zu Quest 3 äußerten wir große Kritik an der fehlenden dynamischen Okklusion für Mixed Reality. Obwohl virtuelle Objekte hinter dem durch das Scannen des Raumaufbaus erstellten rohen Szenenraster erscheinen können, erscheinen sie immer vor sich bewegenden Objekten wie Ihren Armen und anderen Personen, selbst wenn diese weit entfernt sind, was störend und unnatürlich aussieht.

Entwickler können tatsächlich eine dynamische Okklusion Ihrer Hände mithilfe eines Hand-Tracking-Netzes implementieren, aber nur wenige tun dies, da dadurch Ihr Handgelenk abgeschnitten wird, sodass der Rest Ihres Arms nicht einbezogen wird.

Die neue Tiefen-API bietet Entwicklern eine grobe Tiefenkarte jedes vom Headset generierten Frames aus seiner Perspektive. Dies kann verwendet werden, um eine Okklusion durchzuführen, sowohl für sich bewegende Objekte als auch, um feinere Details für statische Objekte zu erhalten, da diese möglicherweise nicht im Szenennetz erfasst wurden.

Durch die dynamische Okklusion soll Mixed Reality in Mission 3 natürlicher aussehen. Die Genauigkeit der Tiefenmessung des Kopfhörers ist jedoch gering sehr Niedrig, sodass Sie keine Details wie die Zwischenräume zwischen Ihren Fingern erkennen und eine leere Lücke an den Kanten von Objekten sehen.

Es wird außerdem vorgeschlagen, die Tiefenkarte auf nur 4 Meter zu skalieren, wonach „die Genauigkeit dramatisch sinkt“, sodass Entwickler möglicherweise auch Scene Mesh für statische Okklusion verwenden möchten.

Es gibt zwei Möglichkeiten, wie Entwickler Sperren implementieren können: hart und weich. Hard ist im Wesentlichen kostenlos, hat aber Ecken und Kanten, während Soft zwar GPU-Kosten hat, aber besser aussieht. Wenn man sich den Meta-Beispielclip ansieht, kann man sich kaum vorstellen, dass sich ein Entwickler für „Hard“ entscheiden würde.

In beiden Fällen erfordert das Blockieren die Verwendung des blockierenden Shaders von Meta oder die spezifische Implementierung in Ihrem eigenen benutzerdefinierten Shader. Es handelt sich nicht um eine Ein-Klick-Lösung und die Unterstützung dürfte für Entwickler einen enormen Aufwand bedeuten.

Zusätzlich zur Okklusion können Entwickler die Tiefen-API auch verwenden, um tiefenbasierte visuelle Effekte in gemischter Realität, wie zum Beispiel Nebel, zu implementieren.

Die Verwendung der Depth-API erfordert derzeit die Aktivierung experimenteller Funktionen auf Ihrem Quest 3-Headset durch Ausführen eines ADB-Befehls:adb shell setprop debug.oculus.experimentalEnabled 1

Unity-Entwickler müssen außerdem eine Betaversion des Unity XR Oculus-Pakets verwenden und Unity verwenden 2022.3.1 oder höher.

Sie können Dokumentation für finden Die Einheit ist da Und für Unrealistisch hier.

UploadVR testet das Schließen der Depth API in Quest 3.

Da es sich um eine Beta-Funktion handelt, können Builds, die die Depth-API verwenden, noch nicht in den Quest Store oder App Lab hochgeladen werden, sodass Entwickler vorerst andere Verteilungsmethoden wie SideQuest verwenden müssen, um ihre Apps zu teilen. Normalerweise stuft Meta in einer späteren SDK-Version Funktionen von der Beta-Phase in die Produktionsphase um.

„Lebenslanger Social-Media-Liebhaber. Fällt oft hin. Schöpfer. Leidenschaftlicher Feinschmecker. Entdecker. Typischer Unruhestifter.“