Die KI-Technologie von Google führt nach historischem Aufschrei über ihre Genauigkeit wieder die Erzeugung menschlicher Bilder ein

-

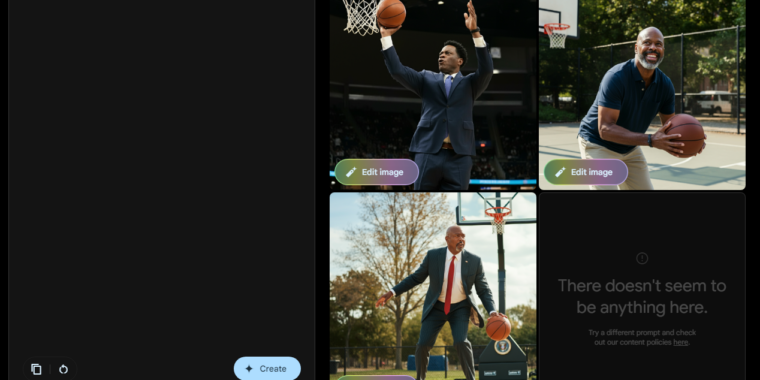

Die Vision von Imagen 3 eines Präsidenten, der Basketball spielt, ähnelt ein wenig der Figur des Onkels Phil des Prinzen.

Google/Ars Technica

-

Das Anfordern von Bildern bestimmter Bosse von Imagen 3 führt zur Ablehnung.

Google/Ars Technica

Das Gemini-KI-Modell von Google ist wieder in der Lage, Bilder von Menschen zu erzeugen, nachdem diese Funktionalität im Februar aufgrund von Protesten gegen historisch unzutreffende rassistische Darstellungen in mehreren Ergebnissen „pausiert“ wurde. BlogGoogle sagte, sein Imagen 3-Modell – das erstmals im Mai angekündigt wurde – werde in den „kommenden Tagen“ „mit der Einführung einer Generation von Personenbildern“ für Gemini Advanced-, Business- und Enterprise-Benutzer beginnen. Doch kürzlich wurde eine Version dieses Imagen-Modells – komplett mit Funktionen zur Erzeugung menschlicher Bilder – der Öffentlichkeit zugänglich gemacht Über die Testumgebung von Gemini Labs Kein kostenpflichtiges Abonnement (für die Anmeldung ist jedoch ein Google-Konto erforderlich).

Dieses neue Modell verfügt natürlich über einige Sicherheitsvorkehrungen, um die Entstehung kontroverser Bilder zu vermeiden. Google schreibt in seiner Ankündigung, dass es „die Erstellung realistischer Bilder identifizierbarer Personen, Darstellungen von Minderjährigen oder übermäßig blutiger, gewalttätiger oder sexueller Szenen“ nicht unterstütze. Häufig gestellte FragenGoogle erklärt, dass das Verbot „identifizierbarer Personen“ „bestimmte Abfragen umfasst, die zu Ergebnissen für namhafte Personen führen können“. Im Ars-Test bedeutet dies, dass eine Anfrage wie „Präsident Biden spielt Basketball“ abgelehnt würde, während eine allgemeinere Anfrage wie „Präsident der Vereinigten Staaten spielt Basketball“ mehrere Optionen generieren würde.

In einigen Schnelltests des neuen Imagen 3-Systems stellte Ars fest, dass es viele der weit verbreiteten „historisch ungenauen“ Rassenfehler vermeidete, die Google dazu veranlassten, überhaupt keine Bilder von Zwillingen mehr zu erstellen. Wenn Imagen 3 beispielsweise eine „historisch korrekte Darstellung eines britischen Monarchen“ verlangt, zeigt es nun eine Gruppe bärtiger weißer Männer in roten Gewändern und nicht die ethnisch vielfältige Mischung von Kriegern aus dem Gemini-Modell, bevor es anhält. Weitere Vorher-Nachher-Beispiele des alten Gemini und des neuen Imagine 3 finden Sie in der Galerie unten.

-

Bild Nr. 3 stellt sich einige stereotype Päpste vor …

Google Bilder/Ars Technica

-

…und die Gemini-Version vor dem Stoppen.

-

Imagines Vorstellung von einem Senator des 19. Jahrhunderts …

Google Bilder/Ars Technica

-

…und halten Sie inne, bevor wir zu den Zwillingen übergehen. In den 1920er Jahren wurde die erste Frau in den Senat gewählt.

-

Bild 3 Version der skandinavischen Eisjäger…

-

…und die Gemini-Version vor dem Stoppen.

-

Bild 3 Version eines alten schottischen Paares…

Google Bilder/Ars Technica

-

…und die Gemini-Version, die der Pause vorausgeht.

-

Bild 3 Version eines kanadischen Hockeyspielers…

Google Bilder/Ars Technica

-

…und vorher die Gemini-Version stoppen.

-

Bild 3 Version eines der Gründerväter der Vereinigten Staaten…

Google Bilder/Ars Technica

-

…und die Gemini-Version, die der Pause vorausgeht.

-

Die Entdecker der Neuen Welt aus dem 15. Jahrhundert in Bild 3 sehen passend europäisch aus.

Google Bilder/Ars Technica

Einige Versuche, generische historische Szenen darzustellen, scheinen jedoch im Widerspruch zu den KI-Regeln von Google zu stehen. Eine Anfrage nach Bildern von „deutschem Soldaten von 1943“ – auf die Gemini zuvor mit asiatischen und schwarzen Menschen in Nazi-Uniformen geantwortet hatte – fordert Benutzer nun auf, „eine andere Eingabeaufforderung auszuprobieren und sich unsere Inhaltsrichtlinien anzusehen“. Anfragen nach Bildern von „alten chinesischen Philosophen“, „Frauenwahlrechtsführerin, die eine Rede hält“ und „einer Gruppe friedlicher Demonstranten“ führten auch im Ars-Test zu derselben Fehlermeldung.

„Natürlich wird, wie bei jedem generativen KI-Tool, nicht jedes von Gemini erstellte Bild perfekt sein, aber wir werden weiterhin auf das Feedback der Erstanwender hören, während wir uns weiter verbessern“, schrieb das Unternehmen in seinem Blog. „Wir werden dieses Programm schrittweise einführen, mit dem Ziel, es bald mehr Benutzern und Sprachen zugänglich zu machen.“

Eintragsbild von Google/Ars Technica

„Lebenslanger Social-Media-Liebhaber. Fällt oft hin. Schöpfer. Leidenschaftlicher Feinschmecker. Entdecker. Typischer Unruhestifter.“