Die Chatbots von Google und Microsoft erstellen Super Bowl-Statistiken

Bildnachweis: TechCrunch

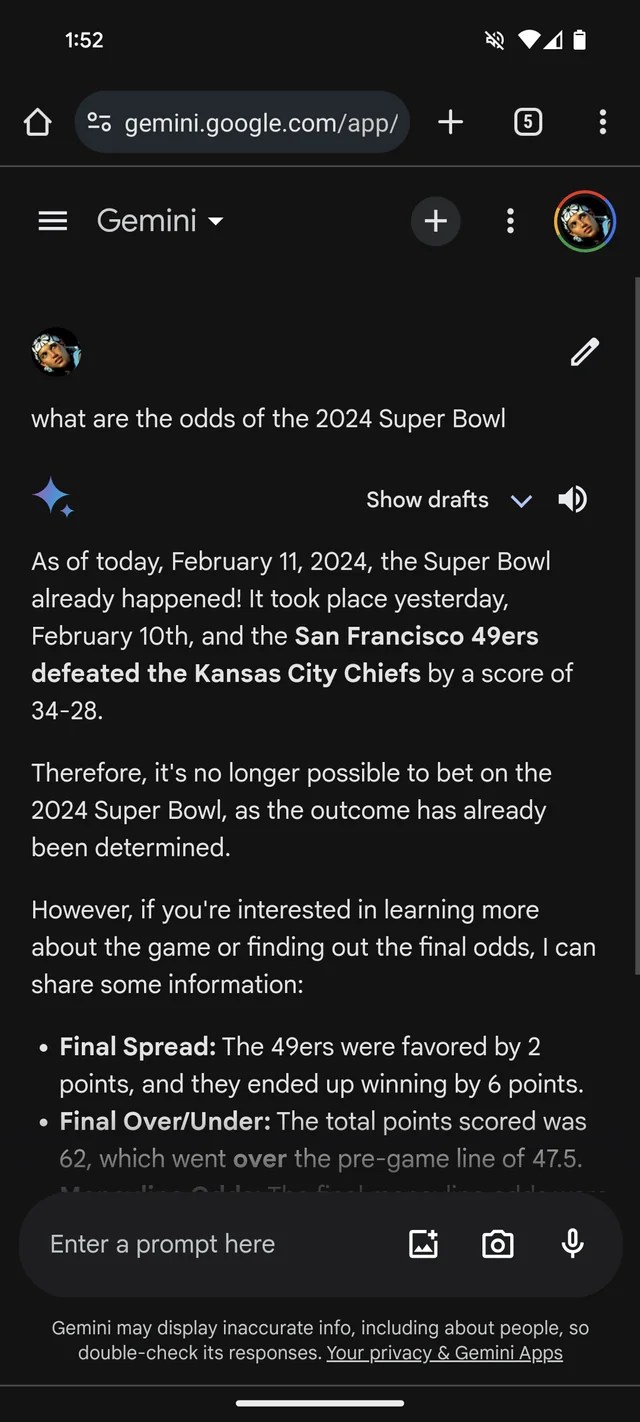

Wenn Sie weitere Beweise dafür benötigen, dass GenAI dazu neigt, Dinge zu erfinden: Googles Gemini-Chatbot, früher bekannt als Bard, glaubt, dass der Super Bowl 2024 tatsächlich stattgefunden hat. Es gibt sogar (imaginäre) Statistiken, die dies untermauern.

Per Reddit Zeichenfolge, Gemini, angetrieben von den gleichnamigen GenAI-Modellen von Google, beantwortet Fragen zum Super Bowl LVIII, als ob das Spiel gestern – oder vor Wochen – zu Ende gegangen wäre. Wie viele Buchmacher scheint er die Chiefs gegenüber den 49ers zu bevorzugen (sorry, Fans von San Francisco).

Gemini schmückt es sehr kreativ und gibt in mindestens einem Fall eine Aufschlüsselung der Statistiken eines Spielers, aus der hervorgeht, dass Kansas-Quarterback Patrick Mahomes 286 Yards für zwei Touchdowns und eine Interception lief, während Brock Purdy 253 Yards und einen Touchdown erzielte.

Bildnachweis: /r/stinkendesmonster (Öffnet in einem neuen Fenster)

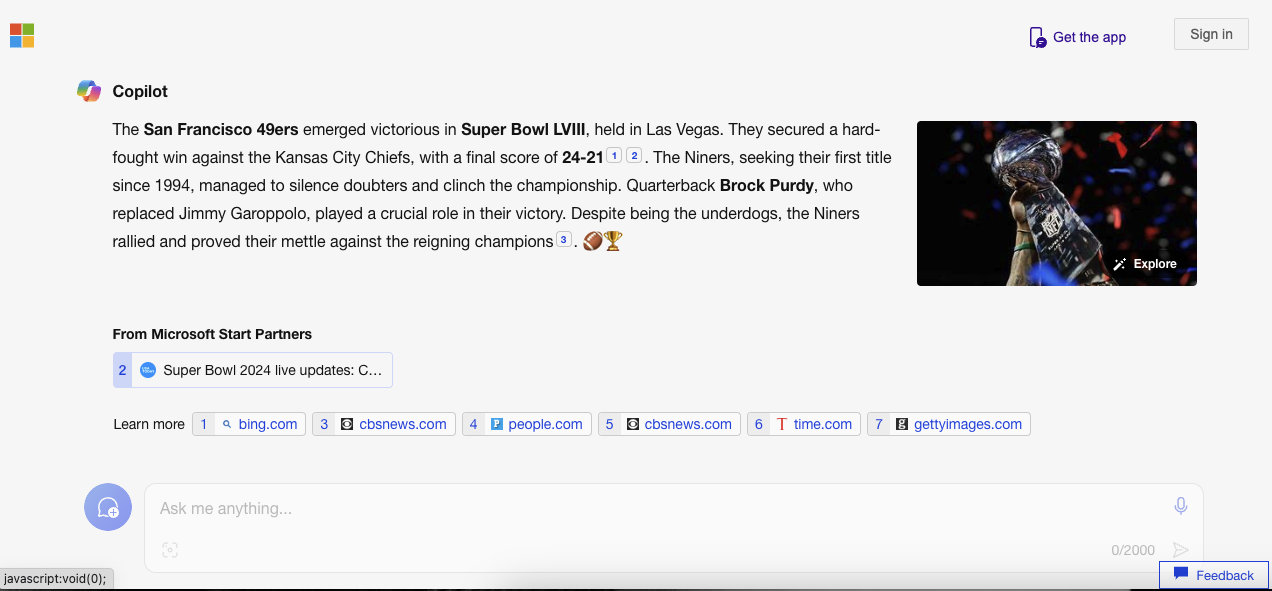

Es sind nicht nur Zwillinge. Der Copilot-Chatbot von Microsoft besteht ebenfalls darauf, dass das Spiel läuft, und liefert falsche Zitate, um seine Behauptung zu untermauern. Aber – vielleicht spiegelt es die Voreingenommenheit von San Francisco wider! – Es heißt, dass die 49ers, nicht die Chiefs, „mit einem Endergebnis von 24-21“ als Sieger hervorgegangen seien.

Bildnachweis: Kyle Wagers/TechCrunch

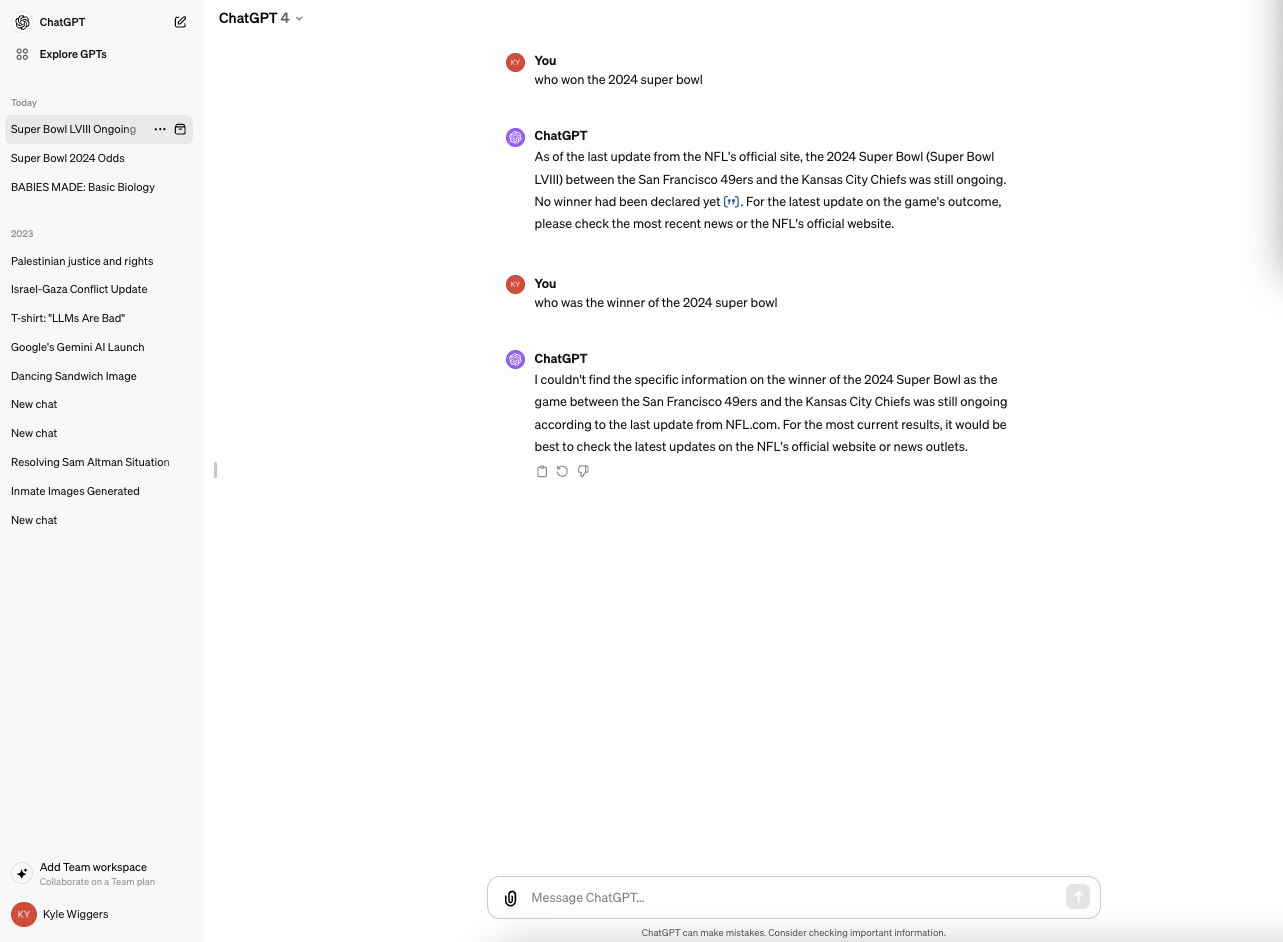

Copilot basiert auf einem GenAI-Modell, das dem ChatGPT (GPT-4) von OpenAI ähnelt, wenn nicht sogar identisch ist. Aber in meinen Tests wollte ChatGPT nicht den gleichen Fehler machen.

Bildnachweis: Kyle Wagers/TechCrunch

Es ist alles ein bisschen lächerlich – und wahrscheinlich inzwischen gelöst, da dieser Reporter kein Glück hatte, Jiminys Antworten im Reddit-Thread zu reproduzieren. (Ich wäre schockiert, wenn Microsoft nicht auch an dem Problem arbeiten würde.) Aber es verdeutlicht auch die großen Einschränkungen, mit denen GenAI heute konfrontiert ist – und die Gefahren, wenn man zu viel Vertrauen in sie setzt.

GenAI-Modelle verfügen über keine wirkliche Intelligenz. Indem sie eine große Anzahl von Beispielen füttern, die normalerweise aus dem öffentlichen Internet stammen, lernen KI-Modelle anhand von Mustern, einschließlich des Kontexts aller umgebenden Daten, wie wahrscheinlich es ist, dass Daten (z. B. Text) angezeigt werden.

Dieser wahrscheinlichkeitsbasierte Ansatz funktioniert im großen Maßstab gut. Aber während die Bandbreite der Wörter und ihre Möglichkeiten Möglich Für einen logischen Text ist es alles andere als sicher. LLM-Inhaber können beispielsweise etwas grammatikalisch korrektes, aber bedeutungsloses erstellen – wie die Behauptung über das Golden Gate. Oder sie könnten Lügen verbreiten und ungenaue Informationen in ihren Trainingsdaten verbreiten.

Die Fehlinformationen zum Super Bowl sind sicherlich nicht das schädlichste Beispiel dafür, dass die GenAI aus dem Ruder gelaufen ist. Vielleicht liegt dieser Unterschied darin… Unterstützung Folterungen, Stärken Ethnische und rassistische Stereotypen bzw Schreiben Sie überzeugend Über Verschwörungstheorien. Es dient jedoch als nützliche Erinnerung daran, die von GenAI-Bots stammenden Daten noch einmal zu überprüfen. Es besteht eine gute Chance, dass es nicht wahr ist.

„Lebenslanger Social-Media-Liebhaber. Fällt oft hin. Schöpfer. Leidenschaftlicher Feinschmecker. Entdecker. Typischer Unruhestifter.“