Apple erläutert neue iPhone-Funktionen wie Türerkennung und Live-Anmerkungen

-

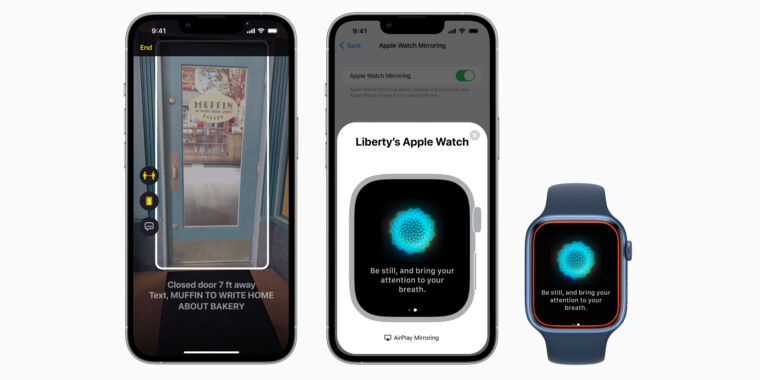

Die Türerkennung verwendet einen LiDAR-Scanner und maschinelles Lernen, um Türen zu identifizieren und Informationen über ihren Standort, ihre Markierung und mehr für blinde oder sehbehinderte Benutzer weiterzuleiten.

-

Auto Transcript transkribiert, was Personen in Anrufen und Videos sagen, während sie das Telefon benutzen.

-

Die Bildschirmspiegelung der Apple Watch gibt Watch-Benutzern Zugriff auf einige Barrierefreiheitsfunktionen, die auf dem iPhone, aber nicht auf der Watch verfügbar sind.

-

Benutzer können einstellen, wie lange Siri wartet, bis Sie fertig sind, bevor es antwortet oder eine Aktion ausführt.

-

Die hinzugefügten Touch-Gesten geben Benutzern mehr Möglichkeiten, die Apple Watch zu steuern.

-

Sie können Ihr iPhone darauf trainieren, wichtige Geräusche wie eine Türklingel zu erkennen.

-

Die Apple Books App führt neue Anpassungsoptionen ein, um Text besser sichtbar zu machen.

Der World Accessibility Awareness Day ist Donnerstag, also hat Apple damit begonnen Newsroom-Blog Diese Woche, um mehrere wichtige neue Barrierefreiheitsfunktionen für iPhone, Apple Watch, iPad und Mac anzukündigen.

Die Live-Untertitel-Funktion wird wahrscheinlich die am häufigsten verwendete sein, die auf iPhone, Mac und iPad verfügbar sein wird. Die Funktion zeigt live aktualisierte, KI-basierte Untertitel für Sprache, die von einer beliebigen Audioquelle auf dem Telefon kommt, unabhängig davon, ob der Benutzer ein Telefon- oder FaceTime-Gespräch führt, Videokonferenzen oder eine Social-Media-App verwendet, Medieninhalte streamt oder ein Gespräch führt mit jemand neben ihnen „.

Der Text (dessen Größe beliebig geändert werden kann) wird oben auf dem Bildschirm angezeigt und zeigt, während die Person spricht. Darüber hinaus können Mac-Benutzer Antworten eingeben und sie anderen Gesprächsteilnehmern vorlesen lassen. Live Captions wird später in diesem Jahr auf unterstützten Geräten („iPhone 11 und höher, iPad-Modelle mit dem A12 Bionic-Chip und höher und Macs mit Apple-Silizium”) in die öffentliche Beta-Phase gehen.

Es gibt auch eine Türerkennungsfunktion. Leider funktioniert es nur auf iPhones und iPads mit einem Lidar-Sensor (wie dem iPhone 12 Pro, iPhone 13 Pro oder neueren iPad Pro-Modellen), aber es scheint nützlich für Menschen zu sein, die blind sind oder eine Sehbehinderung haben. Es verwendet die Kamera und Augmented-Reality-Sensoren des iPhones zusammen mit maschinellem Lernen, um Türen zu lokalisieren und den Benutzern laut mitzuteilen, wo sich die Tür befindet, ob sie offen oder geschlossen ist, wie sie geöffnet werden kann und was es für Schrift oder Aufkleber sein könnte.

Die Türerkennung wird sich der Erkennung von Personen und Fotobeschreibungen im neuen „Erkennungsmodus“ für blinde und sehbehinderte Benutzer in iOS und iPadOS anschließen. Der Apple-Blogbeitrag erwähnte jedoch nicht, wann diese Funktion gestartet wird.

Weitere Ergänzungen zur Barrierefreiheit, von denen Apple sagt, dass sie sehr nahe sind, umfassen 20 neue Voice-Over-Sprachen, neue Handgesten auf der Apple Watch und eine Funktion, mit der Spieler Hilfe von einem „Freund“ mit einer anderen Spielkonsole annehmen können, ohne die Verbindung zu trennen. Darüber hinaus gibt es neue Siri- und Apple Books-Anpassungen, die darauf abzielen, die Zugänglichkeit für Menschen mit Behinderungen, Spracherkennungsanpassungen und Apple Watch-Bildschirmspiegelung auf dem iPhone zu erweitern – wodurch Watch-Benutzer Zugriff auf viele der auf dem iPhone verfügbaren Barrierefreiheitsfunktionen erhalten iPhone aber nicht auf der Uhr. .

Technologiebegeisterte beklagen oft, dass Smartphones (und persönliche Technologie im Allgemeinen) ohne viele aufregende neue Entwicklungen stagnieren. Aber das ist für viele Menschen mit Behinderungen weit von der Wahrheit entfernt. Google, Apple und viele Forscher und Start-ups haben große Durchbrüche erzielt und leistungsstarke neue Zugriffsfunktionen für mobile Geräte bereitgestellt.

Bilderliste von Apfel

„Lebenslanger Social-Media-Liebhaber. Fällt oft hin. Schöpfer. Leidenschaftlicher Feinschmecker. Entdecker. Typischer Unruhestifter.“